爬虫打包app

在互联网时代,许多网站和应用程序都提供了大量的数据。然而,这些数据通常是分散的,需要手动从不同的网站和应用程序中进行收集。这种方式非常费时,因此,爬虫技术成为了一种非常流行的自动化数据收集方法。爬虫技术可以帮助我们从网站或应用程序中收集有用的数据,并将其整合到一个应用程序中,以便我们更方便地获取这些数据。本文将介绍如何使用爬虫技术来打包一个app。

爬虫技术是一种自动化数据收集技术,它可以自动地从互联网上的网站或应用程序中收集数据。爬虫技术可以通过模拟用户的行为来获取数据,例如浏览网页或点击按钮。当爬虫程序执行时,它会自动地遍历网站或应用程序的页面,并收集有用的数据。

要打包一个app,我们需要使用爬虫技术来收集所需的数据。具体来说,我们需要收集以下数据:

1. 应用程序的名称和图标

2. 应用程序的描述和功能介绍

3. 应用程序的下载链接

4. 应用程序的版本号和发布日期

5. 应用程序的评分和评论

为了收集这些数据,我们需要编写一个爬虫程序。爬虫程序可以使用Python等编程语言编写,它可以模拟用户的行为来获取数据。在爬虫程序中,我们需要指定要访问的网站或应用程序的地址,并指定要收集的数据。例如,我们可以使用Python的requests库来发送HTTP请求,并使用BeautifulSoup库来解析HTML页面。

一旦我们收集了所需的数据,我们可以将其整合到一个应用程序中。我们可以使用Android或iOS开发工具来开发应用程序。在应用程序中,我们可以使用SQLite等数据库来存储数据,并使用RecyclerView等控件来展示数据。我们还可以使用Glide等图片加载库来加载应用程序的图标和截图。

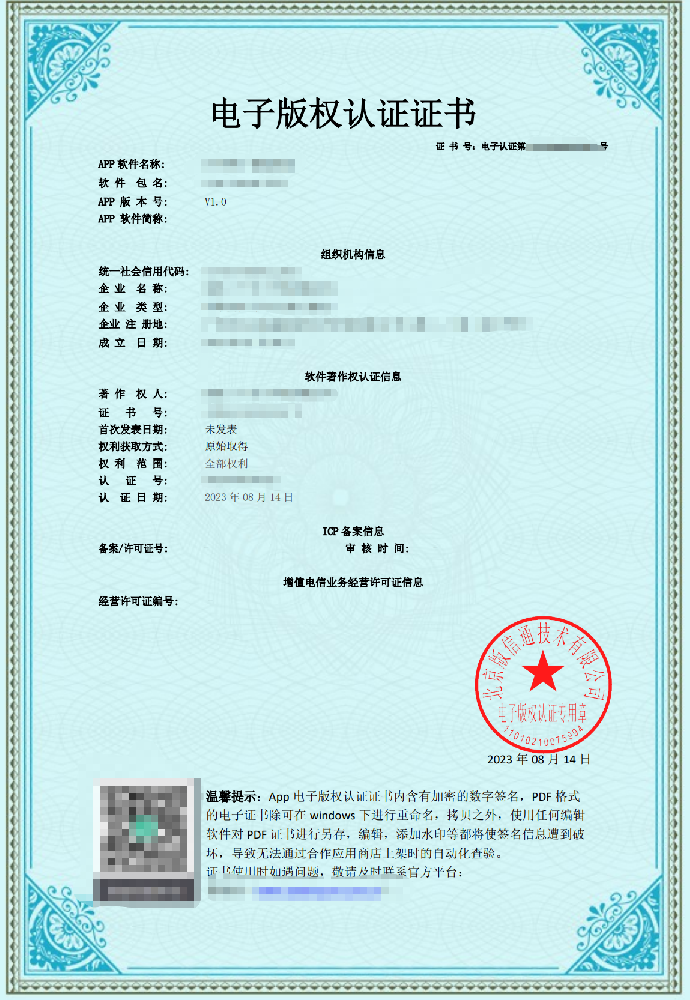

当我们开发完应用程序后,我们可以将其发布到应用商店中。我们可以使用Google Play或App Store等应用商店来发布应用程序。在发布应用程序之前,我们需要确保应用程序符合应用商店的规定,并遵守相关法律法规。我们还需要编写应用程序的描述和截图,并选择适当的应用程序类别和关键字来帮助用户找到我们的应用程序。

在发布应用程序后,我们需要不断地更新应用程序,并收集用户的反馈。我们可以使用Firebase等工具来收集应用程序的使用情况和崩溃报告,并根据用户反馈来改进应用程序。我们还可以使用推送通知等功能来与用户保持联系,提高用户满意度。

总之,爬虫技术可以帮助我们从网站或应用程序中收集有用的数据,并将其整合到一个应用程序中,以便我们更方便地获取这些数据。要打包一个app,我们需要编写一个爬虫程序来收集数据,并使用Android或iOS开发工具来开发应用程序。在发布应用程序后,我们需要不断地更新应用程序,并收集用户的反馈,以提高用户满意度。